Maîtriser la situation :

les défis et les éléments à prendre en considération lors de la mise en œuvre de grands modèles de langage dans le secteur de l’assurance

properties.trackTitle

properties.trackSubtitle

Février 2024

Dans nos articles précédents, nous avons exploré le fonctionnement des grands modèles de langage et nous nous sommes demandé comment ils pourraient transformer les processus de sélection des risques et de gestion des réclamations.

Nous nous penchons maintenant sur les facteurs dont les assureurs doivent tenir compte lorsqu’ils investissent dans de grands modèles de langage et mettent en œuvre. Les trois éléments essentiels sont l’exactitude des grands modèles de langage, le contexte réglementaire en pleine évolution et les coûts prévus.

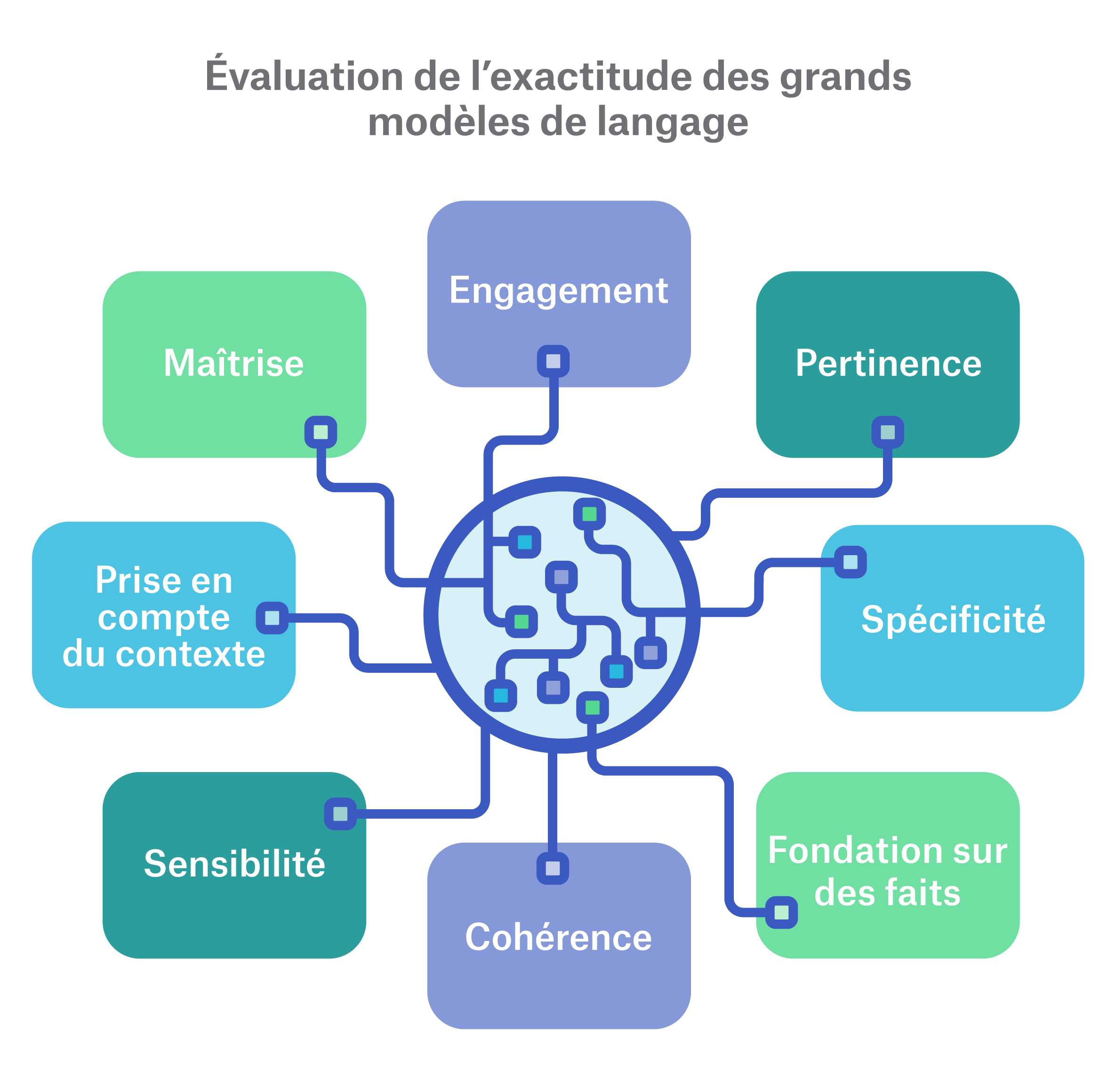

Évaluation de l’exactitude des grands modèles de langage

Les grands modèles de langage sont des systèmes d’intelligence artificielle de style boîte noire qui utilisent l’apprentissage profond pour comprendre et générer du nouveau texte. Des modèles comme ChatGPT d’OpenAI et PaLM de Google ont été créés avec des capacités générales, comme « rédiger une lettre » ou « écrire un poème ». L’évaluation de ces modèles représente un défi, car les grands modèles de langage sont, par conception, non déterministes (il est difficile de toujours prévoir les résultats) et fondés sur le langage (il est difficile de comparer les résultats). Les paramètres d’évaluation comme ROUGE (Recall Oriented Understudy for Gisting Evaluation) et BLEU (Bi-Lingual Evaluation Understudy) sont couramment utilisés pour les tests d’exactitude. Une autre approche courante consiste à utiliser des ensembles d’indices de référence pour comparer le rendement du modèle. Ils portent des noms amusants comme GLUE, SuperGLUE, HELM, MMLU et BIG-bench.

Les indices de référence ont tendance à mesurer l’engagement, la reconnaissance des tâches, la pertinence et la spécificité, et ils constituent tous de bonnes mesures pour un modèle général. Cependant, ils ne sont pas propres à un secteur en particulier. Comme les grands modèles de langage souffrent fréquemment d’hallucinations, c’est-à-dire qu’ils génèrent du texte insensé ou non pertinent, ainsi que de fragilité, ce qui fait référence à des résultats très variés provenant de petits changements apportés aux données entrées, un cadre de référence et d’évaluation pertinent est essentiel à leur adoption dans les situations où l’uniformité et l’exactitude sont une priorité absolue.

À mesure que nous appliquerons les grands modèles de langage dans le domaine de l’assurance, des cas, de nouvelles mesures de test et des indices de référence devront être élaborés. En raison de la nature précise et exacte des activités du domaine de l’assurance, ces cadres doivent être assez rigoureux et robustes pour donner aux assureurs un sentiment de confort lors du déploiement d’un grand modèle de langage dans un environnement de production. Les cadres génériques n’ont pas encore atteint ce niveau de spécificité dans le secteur de l’assurance, d’où la nécessité d’utiliser des cadres propres aux cas pour évaluer l’exactitude.

Considérations législatives

La nature révolutionnaire des grands modèles de langage a soulevé de véritables préoccupations quant à la viabilité de ces modèles en tant qu’outils sécuritaires et fiables. Les principaux éléments à prendre en considération pour les organismes législatifs comprennent la façon dont les grands modèles de langage obtiennent leurs résultats (c.-à-d. l’explicabilité) et l’établissement des principes directeurs et des règles précises en vertu desquels ils fonctionnent, en mettant l’accent sur la protection des renseignements et des droits de la personne.

Les assureurs doivent être à l’aise à l’idée que les grands modèles de langage travaillent sans parti pris, produisent des résultats explicables et ne manquent pas des renseignements importants qui peuvent avoir une incidence sur un résultat ou une décision. Par conséquent, les grands modèles de langage que nous entraînons et mettons en place nécessitent des tests de parti pris rigoureux afin de nous assurer que les systèmes de prise de décision automatisée respectent les lignes directrices législatives. Une fois le processus terminé, nous pouvons nous concentrer sur les simulations de crise pour nous assurer qu’ils donnent les résultats escomptés, c’est-à-dire qu’ils maîtrisent la situation.

À cette étape-ci, nous nous attendons à ce que la législation accepte les grands modèles de langage et en tienne compte. Plusieurs territoires de compétence envisagent de mettre en place des lois visant à limiter ou à contrôler l’utilisation de l’intelligence artificielle générative (plus précisément, les grands modèles de langage) tout en maintenant le droit des consommateurs à l’information et à l’objection.

Au Canada, le projet de loi C-27 cherche à moderniser et à remplacer sa législation sur la protection des renseignements personnels, la Loi sur la protection des renseignements personnels et les documents électroniques (LPRPDE), et à présenter la Loi sur l’intelligence artificielle et les données (LIAD). Au Québec, la loi 25 vise à assurer la transparence et la responsabilisation des systèmes de prise de décision automatisée qui utilisent des renseignements personnels.

Aux États-Unis, le National Institute of Standards and Technology (NIST) a tenu des discussions avec les secteurs public et privé afin d’élaborer des normes nationales pour la création de systèmes d’intelligence artificielle fiables, robustes et dignes de confiance, et au moins 25 États ont présenté des projets de loi visant à examiner et à établir des normes en matière d’intelligence artificielle au cours de la session législative de 2023.1

Tout cadre législatif élaboré sera général, et les assureurs devront décrire des pratiques plus précises pour notre secteur qui mettent l’accent sur la responsabilité, la conformité, la transparence et la sécurité. Il sera important pour le secteur (les réassureurs, les assureurs et les organismes de réglementation du domaine de l’assurance) de se rassembler et, ultimement, de créer des cadres législatifs pratiques pour les grands modèles de langage du domaine de l’assurance.

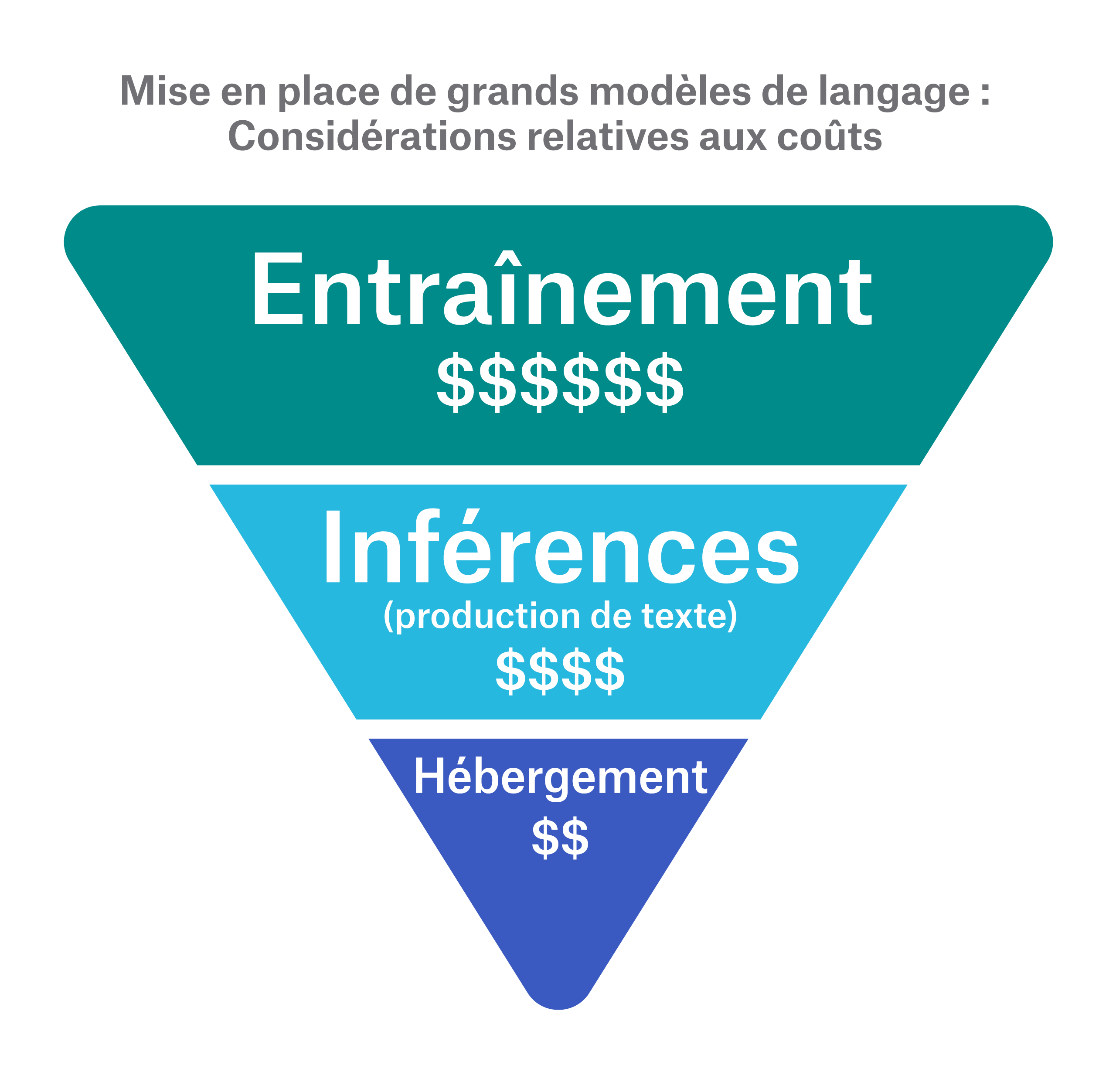

Considérations relatives aux coûts

Il ne fait aucun doute que le secteur de l’assurance finira par être à l’aise avec la viabilité, l’exactitude et le respect de la réglementation des grands modèles de langage. Cependant, la question du coût demeure. Comme facteur essentiel dans l’opérationnalisation de la technologie des grands modèles de langage, les assureurs doivent évaluer les coûts prévus pour l’hébergement, l’inférence (c.-à-d. la production de textes), l’entraînement et, bien sûr, les ressources spécialisées. Nous pouvons considérer ces coûts comme un triangle inversé, avec l’hébergement au bas, car ce coût est généralement définitif, et l’entraînement au sommet en raison de son important écart de coût.

Les coûts d’hébergement et de production d’inférences sont généralement combinés et dépendent de la taille du modèle (le nombre de paramètres donne une bonne approximation) et de la fréquence à laquelle le modèle est utilisé pour la production d’inférences. N’oubliez pas que ces modèles sont énormes, et que cette ampleur nécessite plusieurs unités de traitement graphique pour l’hébergement et les inférences. Les configurations infonuagiques à unités de traitement graphique multiples entraînent des coûts plus élevés que ceux qui sont habituellement exigés pour les serveurs normaux. Par exemple, un modèle de 7 milliards de paramètres pourrait coûter jusqu’à 30 000 $ US par année en hébergement, tandis qu’un modèle de 40 milliards de paramètres pourrait coûter jusqu’à 180 000 $ US. La taille et l’utilisation sont des facteurs importants lorsqu’on se penche sur les coûts.

L’entraînement est un tout autre aspect de la question. Les coûts d’entraînement varient grandement, allant de centaines, voire de milliers de dollars, pour le réglage fin efficace des paramètres (contenu en anglais seulement) à des millions de dollars pour le réglage fin complet. La plupart des organisations effectuent un certain niveau de réglage fin efficace des paramètres dans le cadre duquel seul un sous-ensemble des pondérations initiales (ou un petit nombre de pondérations supplémentaires) sont réglés finement, ce qui réduit considérablement les coûts. Bien qu’elle ne soit pas spécifiquement considérée comme un entraînement (lorsque les pondérations du modèle sont modifiées), la génération augmentée de récupération (contenu en anglais seulement) est une technique économique qui permet aux grands modèles de langage de fonctionner uniquement sur des renseignements stockés dans des bases de données spéciales appelées bases de données vectorielles. Cette approche est couramment utilisée pour réduire considérablement les coûts d’entraînement de centaines, voire de milliers de dollars.

Les coûts liés aux ressources, comme ceux nécessaires pour créer des ensembles de données aux fins d’entraînement, sont généralement négligés. Peu importe la technique utilisée, ces modèles ont besoin de données. Il faudra du temps et des ressources pour épurer de grands ensembles de données aux fins d’entraînement. Cela ajoutera des coûts de ressources supplémentaires qui ne doivent pas être ignorés.

Regard vers l’avenir

Les grands modèles de langage sont de nature transformatrice quant à leur capacité à exploiter efficacement les renseignements difficiles à atteindre. Ils peuvent synthétiser des données non structurées provenant de différentes sources et personnifier ces renseignements, ce qui pourrait offrir aux assureurs une nouvelle façon efficace d’interagir avec leurs données les plus précieuses. Les assureurs qui disposent de précieuses données non structurées exclusives propres à leur domaine (p. ex. des données de sélection des risques médicaux) pourraient obtenir un avantage concurrentiel en tirant parti de renseignements auparavant inaccessibles à partir de ces données.

Les possibilités d’utilisation dans le domaine de l’assurance sont nombreuses. Dans cette série d’articles, nous avons abordé deux aspects, la sélection des risques et la gestion des réclamations, pour lesquels l’adoption des grands modèles de langage pourrait être particulièrement révolutionnaire.

Pourtant, pour chaque promesse, il faut tenir compte de la réalité. L’entraînement et l’exploitation des grands modèles de langage peuvent être coûteux. Cependant, il existe des solutions de contournement pour réduire les coûts, et les technologies sous-jacentes et les cadres d’évaluation s’améliorent. De plus, la législation axée sur la protection des renseignements personnels et des droits de la personne est une priorité pour les gouvernements. Ce sont d’excellents éléments de base pour veiller à un avenir où l’adoption de cette technologie ne surpassera pas sa capacité à être contrôlée.

Par conséquent, les grands modèles de langage présentent un énorme avantage en assurance. Travailler ensemble en tant qu’industrie pour établir des principes rigides régissant l’adoption de cette technologie nous aidera à nous assurer que nous maîtrisons la situation et que nous mettons en œuvre les grands modèles de langage des manières les plus avantageuses possibles.